隨著ChatGPT、Claude、Copilot等人工智慧工具的廣泛應用,許多領域已與大型語言模型深度融合,顯著提升整體服務品質與營運效能,為各行各業帶來前所未有的變革與發展機遇。然而,資訊技術的發展總伴隨著資訊安全的潛在風險,這已成為不可忽視的重要議題。

國際知名的資訊安全組織OWASP(參考:OWASP Top 10 2021入門介紹)在2023年即啟動了Large Language Model Applications計畫,專門研究大型語言模型(LLM)應用可能面臨的資安風險,類似於之前粉絲文中所介紹Web風險弱點。該計畫聚焦於各領域在LLM模型開發、設計與應用階段時應關注的威脅與資安弱點。目前,該計畫最新的版本 – OWASP Top 10 for LLM Applications 2025,已於2024年11月17日正式發布。

為了讓大家更清楚了解LLM的潛在風險,本系列內容將分為三個部分進行介紹:

- LLM架構解析:首先,我們將介紹LLM的基本架構,幫助大家理解其運作原理,包括使用者輸入、模型運行、外部服務交互以及模型更新等關鍵流程。

- OWASP Top 10 for LLM Applications (上篇):接著,我們將剖析OWASP Top 10 for LLM Applications中的LLM01~LLM05,詳細說明每項風險的定義、攻擊手法、實際案例與對應的防範措施。

- OWASP Top 10 for LLM Applications (下篇):最後,我們將進一步解析 LLM06~LLM10,補充更多與LLM應用安全相關的風險,確保大家能夠全面認識LLM的潛在威脅,降低LLM系統的安全隱患。

隨著LLM技術的快速發展,資訊安全風險也隨之提升。希望透過本系列的介紹,幫助大家更有系統地理解LLM資安議題,進而強化應用防護,確保系統穩定與安全!

LLM架構

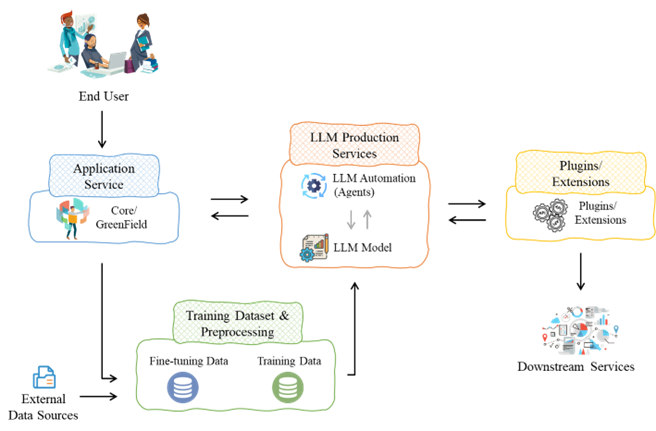

從下圖中,我們可以看到一個簡易的LLM架構。儘管整體框架看起來較為複雜,但我們先認識每個元件的功能與意義,其核心運作方式將會透過簡單的情境來理解。

- End User:LLM模型的使用者。

- Application Service:Core/GreenField: 供使用者的應用程式服務,如ChatGPT的服務介面。

- LLM Production Services:

- LLM Automation(Agents): 負責調用、管理、交互。

- LLM Model: 負責內容理解、分析、推理、生成。

- Plugins/Extensions:LLM串接的應用功能。

- Downstream Services:根據LLM結果,進一步處理或應用於其他系統。

- Training Dataset & Preprocessing

- Training Data: 用於建立模型基本能力,包括語言理解、分析、推理、生成之資料集。

- Fine-tuning Data: 用於微調模型的資料集,以適應特定任務或行業需求。

- External Data Sources:提供模型即時查詢的資料、文件、知識庫。

接下來,將為大家講述一個直觀的案例,幫助大家更輕鬆地掌握LLM的基本概念與應用方式。

- 使用者輸入:End user透過application service(ChatGPT、Claude、Copilot)輸入對話內容(prompt),類似我們開啟ChatGPT頁面進行提問的方式。

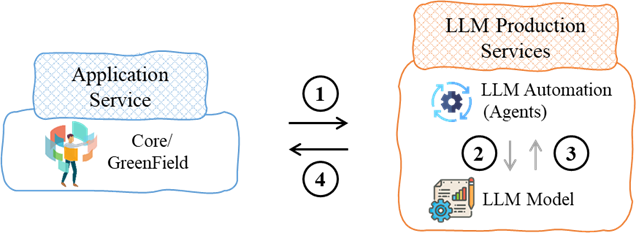

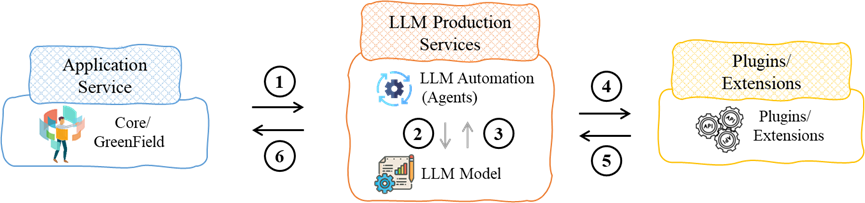

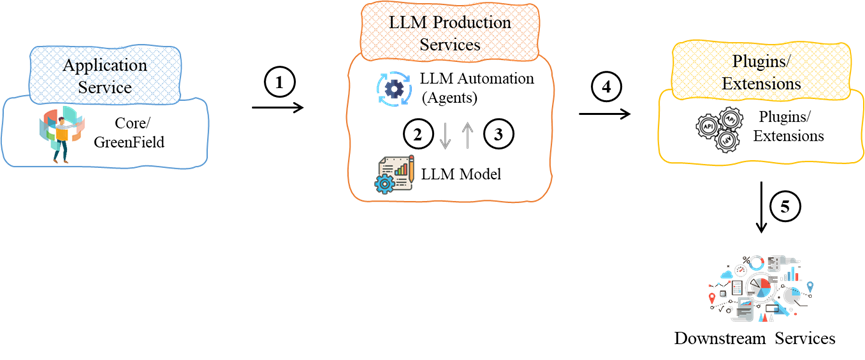

- 模型運作:Application service會將問題傳送至LLM production services,模型隨後執行理解、分析、推理與生成等處理程序。根據需求,模型可能會採取以下處理方式:

- 無需額外擴充功能:系統直接在LLM production services內部生成回覆,並回傳至application service,供使用者查看結果。

- 需額外擴充功能:若LLM需要額外工具來處理請求,如計算、程式碼執行,則可能透過Plugin/Extension機制進行額外運算,完成後回傳結果至 Application Service。

- 需下游服務:若系統需要存取外部資料,如企業資料庫、核心應用程式或網站,則可透過plugin轉發請求至 downstream services。

- 模型訓練與微調:Training Dataset & Preprocessing是 LLM 訓練與優化的核心流程,其資料來源可分為:

- 使用者輸入的內容可能會被收集來優化未來模型版本,但不會直接影響當前模型。

- 外部資料庫,如維基百科、新聞、學術論文等,可作為 LLM 訓練時的基礎資料。

透過本篇文章,我們解析了LLM的基本架構,從使用者輸入到模型運行,再到外部服務交互與模型更新,讓大家對LLM的運作方式有了更清晰的理解。然而,除了技術架構外,LLM應用的安全性也是不可忽視的重要課題。在下一篇文章中,我們將聚焦於OWASP Top 10 for LLM Applications,探討LLM應用可能面臨的前五大安全風險,並解析對應的攻擊手法。

【參考資料】

- OWASP Top 10 for LLM Applications 2025,https://genai.owasp.org/resource/owasp-top-10-for-llm-applications-2025/,2024-11

By Jared