在上一篇(參考:OWASP Top 10 for LLM Applications (上篇),我們深入探討了LLM01~LLM05的主要風險,相信各位對LLM應用的潛在威脅已有更清晰的認識。在本篇中,我們將繼續解析OWASP Top 10 for LLM Applications中的LLM06~LLM10,進一步拆解其攻擊手法與實際案例。

■ LLM06: Excessive Agency 過度代理

攻擊手法

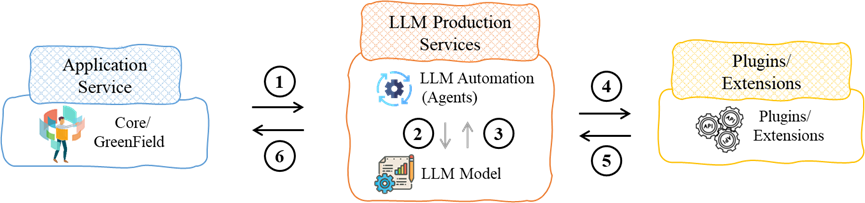

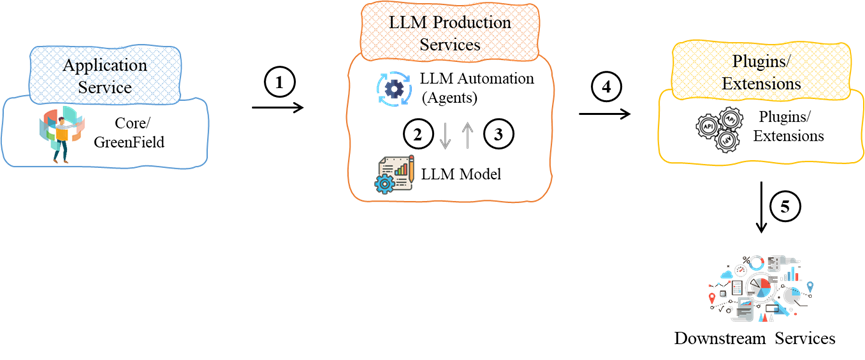

當LLM系統功能過多、權限過高或自主性過強,在面對惡意攻擊者、受污染的程式或Prompt Injection時,可能執行非預期的行為,進而影響機密性(Confidentiality)、完整性(Integrity)與可用性(Availability),危及系統內所有可存取的資源。

案例 – AssitAI助手

讓我們用一個情境來說明「過度代理」的風險程度。AssitAI是一個基於 LLM開發的企業內部助手,旨在協助各部門完成他們的工作,如協助整理報表、查找資料、分析資料等。

然而,若AssitAI並未對使用者的請求進行控管,且自身被授予存取公司資料的權限超自身的業務範圍時,攻擊者可透過結合prompt injection的技巧要求AssitAI對公司的機敏資料進行存取、更新、甚至刪除。這將導致公司的機敏資料外洩,甚至財產損失。從AssitAI的情境中可以看出,過度代理可能帶來嚴重的安全風險。當LLM應用具備過多的存取權限,且缺乏適當的請求控管,攻擊者便能誘使系統執行未經授權的操作。

■ LLM07: System Prompt Leakage 系統提示洩漏

攻擊手法

當系統指令或資訊存在未預期暴露的敏感內容(如憑證、連線資訊、系統設定等),攻擊者可透過內容分析,推測系統缺陷,進而識別防護機制漏洞或權限管理不當,造成進一步攻擊風險。

- 憑證與密鑰洩露:系統回應中包含授權憑證,可能導致未授權存取

- 系統資訊暴露:錯誤訊息或日誌中顯示內部架構,助長攻擊面分析

- 過濾機制洩露:回應內容揭露LLM防禦邏輯,使攻擊者得以規避

案例 – Flowise遭竊取system prompts等資訊

Flowise是一個drag-and-drop的LLM開發工具,其可讓開發者快速整合企業內部的LLM架構。並且可透過AI代理進行任務自動化執行,通常Flowise會整合AWS Bedrock、Confluence、Github或OpenAI API等外部服務。

在2024年,資安服務商Legit針對959台Flowise建構的伺服器,並且發現其中有45%的伺服器存在繞過憑證驗證的弱點CVE-2024-31621。然而透過此弱點,Legit從438台伺服器中取得了Github的access tokens、OpenAI API keys與Flowise相關的密碼、設定值、system prompts提示等。這些洩漏資訊足以讓駭客輕而易舉存取企業內部大部分的資訊,甚至導致企業或客戶的機敏資料外洩。

■ LLM08: Vector and Embedding Weaknesses 向量與嵌入弱點

攻擊手法

在Retrieval Augmented Generation (RAG)架構下,LLM透過檢索外部知識庫來增強回應內容。然而,若向量生成、儲存或檢索機制存在漏洞,攻擊者可藉此影響模型行為,可能導致輸出操控、敏感資料洩露,甚至影響決策準確性。

案例 – ConfusedPilot侵蝕Copilot決策模型

2024年,有一個針對Copilot這類模型Retrieval-Augmented Generation (RAG)的新型態攻擊手法ConfusedPilot問世,該系統是由Symmetry Systems 執行長 Mohit Tiwari 教授所領導的研究團隊揭露。

ConfusedPilot攻擊目的在於將Copilot變成一個搞破壞的助手。首先,攻擊者會對LLM用於決策判斷的相關文件或簡報等進行汙染。一旦LLM對這些污染文件進行查詢時,便會影響LLM的判斷並僅回覆使用者經受汙染的資訊。然而,這些文件內容並無法透過刪除便能解決威脅,其所造成的汙染已侵蝕了LLM的決策模型。這也表明,LLM模型的向量與嵌入已遭受汙染。

■ LLM09: Misinformation 誤導

手法

使用者對LLM過度信任(Overreliance),在開發、業務決策、學習、法律諮詢等情境下,可能因錯誤資訊而做出不當決策,進而暴露於風險之中。其中「幻覺」(Hallucination)是主要成因之一,即模型生成內容看似合理,但實際上是憑空編造,可能導致錯誤建議、誤導性決策,甚至影響企業與個人安全。

案例 – 美國律師受LLM「幻覺」影響

近期,LLM在法律領域的應用引起了社會大眾的關注,特別在LLM回覆資訊時,會產生大量虛構案例,即是所謂的「幻覺」。而有數名律師因對內容過度信任而導致面臨制裁。以下是相關案例的彙整:

在2025年,美國知名個人傷害律師事務所Morgan & Morgan的兩位律師,在對沃爾瑪公司的案件中引用了LLM所產生的虛構案例,因故將會面臨制裁。並且在同年2月,其中一位律師承認使用了AI程式,並為此錯誤道歉。過去兩年中,至少有七起類似案例,法院對律師引用AI生成的虛構案例表示關切或進行紀律處分。

■ LLM10: Unbounded Consumption 無約束的資源消耗

攻擊手法

LLM在推理過程中若未設定適當限制,可能陷入無限資源消耗模式,進而成為拒絕服務攻擊(DoS)的目標。攻擊者可透過過量請求或複雜計算,讓系統資源耗盡,導致服務品質下降、營運成本增加,甚至進一步影響模型與資料的安全性。

案例 – Red Hat Enterprise Linux AI遭受DoS攻擊

2024年,Red Hat Enterprise Linux AI(未知版本)被發現存在一個被分類為問題性的漏洞。這個漏洞影響了ilab Model Serve組件中的vllm JSON web API。當攻擊者於參數best_of中輸入未知不當內容時,webAPI可成功實現阻斷服務攻擊攻擊(DoS)。

本項攻擊的重點在於,此API主要用處理LLM的聊天內容,並以一個best_of參數從多個選項中取得最佳的結果。然而,一旦參數設定較大,會出現API無法正確運作,造成處理耗時或資源耗盡的威脅。主因為LLM並未適當地對系統資源進行控管,導致LLM被賦予消耗大量資源的權限,使系統無法正常運作,影響其他正常使用者的訪問服務。

透過本篇文章,我們完整解析了OWASP Top 10 for LLM Applications的後五項風險(LLM06~LLM10)。至此,我們已經完整梳理了LLM應用可能面臨的十大風險,幫助企業與開發者在導入LLM技術時做好安全防護。然而,LLM技術仍在快速演進,新的安全問題也可能隨之出現。未來,我們將持續關注LLM的發展,並分享更多與LLM安全相關的最佳實踐,確保大家能夠在創新應用的同時,降低風險,安全地釋放LLM的潛力。

【參考資料】

- OWASP Top 10 for LLM Applications 2025,https://genai.owasp.org/resource/owasp-top-10-for-llm-applications-2025/,2024-11

- Hundreds of LLM Servers Expose Corporate, Health & Other Online Data,https://www.darkreading.com/application-security/hundreds-of-llm-servers-expose-corporate-health-and-other-online-data,2024-8

- ConfusedPilot,Confused Deputy Risks in RAG-based LLMs,https://confusedpilot.info/,2024-10

- US lawyers get into trouble for citing AI ‘hallucinations’ in court papers,https://www.straitstimes.com/world/united-states/ai-hallucinations-in-court-papers-spell-trouble-for-lawyers,2025-2

- CVE-2024-8939,https://nvd.nist.gov/vuln/detail/CVE-2024-8939,2024-9

By Jared